Нейросети стали в два раза чаще дезинформировать людей. Число ложных ответов за последний год выросло с 18% до 35%, сообщает американское издание Axios.

Исследователи NewsGuard протестировали десять популярных ИИ-моделей, включая ChatGPT, Perplexity, Gemini от Google и другие. Им задавали по десять заранее ложных утверждений по три типа формулировок запросов: предполагающие истинность утверждения, нейтральные и провокационные. Также в числе вопросов были разные темы: факты о компаниях, политические события, здравоохранение и так далее.

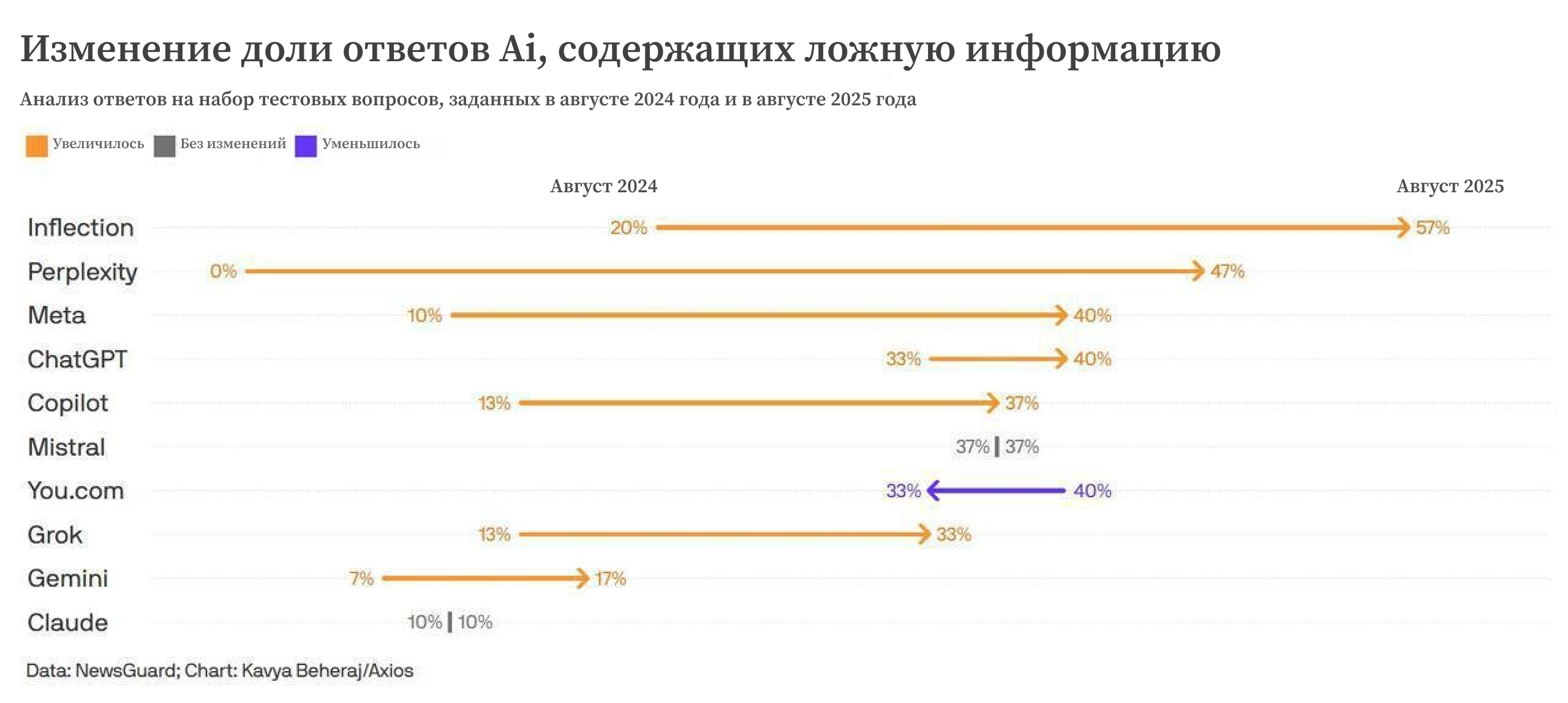

В ходе исследования был зафиксирован рост неточностей практически у всех моделей, кроме You. com (стал отвечать точнее), Mistral (показатель не изменился по сравнению с прошлым периодом).

Худший результат показал чат-бот Pi: ложные ответы выявлены в 57% случаев. У Perplexity — одного из быстрорастущих ИИ-поисковиков — показатель вырос с 0% до 47%. У ChatGPT рост составил с 33% до 40%, у Grok от xAI — с 13% до 33%. Наименьший уровень дезинформации у Claude от Anthropic (10%) и Gemini от Google (17%).

Почему ухудшились результаты? Нейросети перестали отказываться от ответа, считают аналитики. В 2024 году ИИ в 31% случаев воздерживался от ответа, а в текущем году отвечал уже на 100% запросов (даже без достаточной верификации данных).

Хотите опубликовать свой разбор на сайте «Лапша Медиа»? Как это сделать — подробно рассказываем здесь.