Пожилые супруги из Малайзии преодолели более 370 километров, чтобы посетить канатную дорогу, которую они увидели в соцсетях. Но, приехав на место, они обнаружили, что видео было создано с помощью искусственного интеллекта, а самой достопримечательности не существует вовсе, следует из вирусного сообщения в Threads*, о котором написали несколько СМИ.

Как утверждается, пожилая пара из Малайзии следовала из Куала-Лумпура в Перак. Сотрудница отеля по имени Дайя, в котором остановилась пара, сообщила, что пара якобы пыталась узнать у нее, посещала ли она канатную дорогу в Куак Хулу. Пара рассказала ей, что видела достопримечательность в новостях.

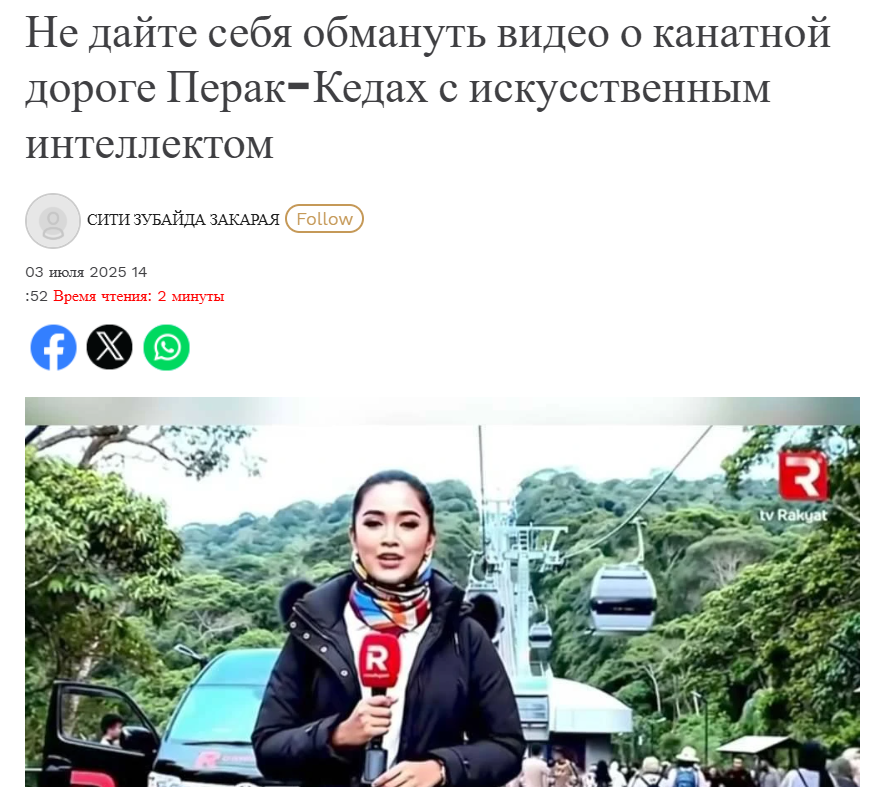

Однако в действительности это было видео ИИ, созданное по мотивам новостных сюжетов. В нем нейрожурналистка телеканала TV Rakyat рассказывает о канатной дороге и берет интервью у сгенерированных посетителей. В ролике видно, как люди выстраиваются в очереди у билетной кассы, в то время как туристы фотографируют достопримечательность. Путешествие по канатной дороге проходит вдоль живописных видов, тоже созданных ИИ. Кроме того, в видео присутствует водяной знак VEO 3, указывающий, что это нейросеть.

Супружеская пара долго не могла поверить, что канатная дорога — это всего лишь иллюзия. Они не могли понять, зачем журналистке из видео обманывать людей. В конце концов, пожилая женщина заявила, что хочет подать в суд на канал. Однако сотрудница отеля напомнила, что журналистка и канал также созданы искусственным интеллектом.

Сотрудница отеля опубликовала пост в соцсетях, в котором рекомендовала туристам проверять информацию о достопримечательностях, которые они планируют посетить. Этот инцидент привлек внимание местной полиции.

Районный офицер Балинга Язлан Сунарди Че Яхая призвал общественность быть осторожнее с вирусным контентом и объяснил, что видео о канатной дороге создано ИИ. Он допустил, что такую достопримечательность могут создать, потому что это позволяет рельеф, но пока ее не существует.

Это не единственный случай, когда использование Veo 3, вводило в заблуждение. Например, вирусным стало видео с кенгуру. В ролике запечатлен момент, когда животное стоит в аэропорту с билетом в руках, а хозяйка спорит с сотрудником аэропорта. Некоторые пользователи поверили в ролик из-за того, что Австралия знаменита необычной фауной и ситуация выглядела правдоподобной.

Также за чистую монету принимали нейроролик с туристкой, которая разбила камнем стеклянный мост в Китае. Несмотря на то, что стекло на переправе крошилось неправдоподобно.

Более того, журнал Time опубликовал несколько видеороликов, созданных с помощью Veo 3. На одном из них запечатлена толпа людей, которые размахивают флагами Пакистана на фоне горящего индуистского храма. На другом — палестинцы выстраиваются в очередь за гуманитарной помощью под присмотром американских военных, повторяя при этом: «Спасибо, США!».

Несмотря на то, что некоторые видео нейросетей маркированы соответствующими знаками, а у персонажей может быть несколько пальцев или неестественные пропорции, пользователи все равно могут счесть их реальными при быстром ознакомлении с контентом, например, листая ленту.

Поэтому проверка информации о маршруте при путешествии обязательна. И проводить ее не стоит с помощью нейропомощников, потому что они, как известно, могут «галлюцинировать». То есть предоставлять недостоверные сведения. Так, к примеру, случилось с туристом, который доверился GhatGPT и решил, что для поездки в Чили ему не нужна виза.

Искусственный интеллект не справляется, потому что ему не хватает логики, опыта и ответственности, он может писать тексты или код, но не понимает смысл того, что делает.

*Принадлежит организации Meta, признана экстремистской в РФ.

Хотите опубликовать свой разбор на сайте «Лапша Медиа»? Как это сделать — подробно рассказываем здесь.