Технология дипфейка за последнее время сделала гигантский шаг вперед. Если изначально она была просто развлекательным инструментом, то теперь ее используют не только во благо. Все больше упоминаний дипфейк получает в свете криминальных и скандальных историй, а также производства дезинформации и черного пиара в политике.

Что понимают под термином «дипфейк»?

Значение слова «дипфейк» восходит к английским deep learning — «глубокое обучение» и fake — «подделка». Часто, когда говорят об этой технологии, то подразумевают, что дипфейк — это когда настоящее лицо человека на видео или фото заменяют другим с помощью искусственного интеллекта (ИИ, или английское AI). Но в действительности возможности технологии шире: это и подделка голосовых записей, и создание искусственного персонажа с нуля.

В сети масса развлекательный роликов, где, к примеру, вместо Арнольда Шварцнеггера в «Терминаторе» играет Бред Питт, в «Сиянии» снимается Джим Керри, а песню группы «Земляне» исполняет Илон Маск.

Как развивалась технология

Изначально этот инструмент был исключительно на службе искусства. Дипфейки применяли в кино. К примеру, для создания образа Голума из фильма «Властелин колец». Также можно вспомнить историю производства «Аватара», где применялась технология facial motion retargeting. Этот инструмент переносил мимику актеров на трехмерных персонажей.

На сегодняшний момент есть большое количество приложений, где используется технология дипфейк, и доступна она широкому кругу лиц прямо со смартфона.

Для создания подобного контента нужны образцы голоса, а также фото или видео. У знаменитостей, хотят они этого или нет, в силу своей профессиональной деятельности большое количество подобных исходников. И даже если человек не является медийным, то изображения с ним можно найти в его соцсетях, а голосовые сообщения — в мессенджерах.

Позитивное использование технологии

Дипфейки активно используют в кино, маркетинге, журналистике, арт-проектах и сфере образования. К примеру, компания «Мегафон» сняла рекламу с голливудским актером Брюсом Уиллисом, а точнее, применив дипфейк звезды. Технология помогла снять ролик быстрее и дешевле.

Также есть большое количество моделей и блогеров, созданных с помощью ИИ. Они не являются реальными людьми, но рекламируют товары и услуги для человека.

Огромное количество примеров использования дипфейков в развлекательных целях. Так, в 2020 году в сети стал популярным ролик, где владелец компании Space X Илон Маск, а точнее его «двойник», пел советский хит «Трава у дома» группы «Земляне». Ролик обрел популярность в связи с тем, что песня связана с космической отраслью, как и деятельность Маска.

Добавим, что персона бизнесмена и создателя соцсети X (бывш. Twitter) была популярна и в контексте современной журналистики. На форуме «Диалог о фейках», который прошел 22 ноября 2023 года в Москве, любой человек мог в режиме реального времени «примерить» лицо предпринимателя при помощи специальной программы. При этом за несколько дней до форума в сети появился ролик, сделанный искусственным интеллектом, в котором двойник Маска приглашал сам себя на форум.

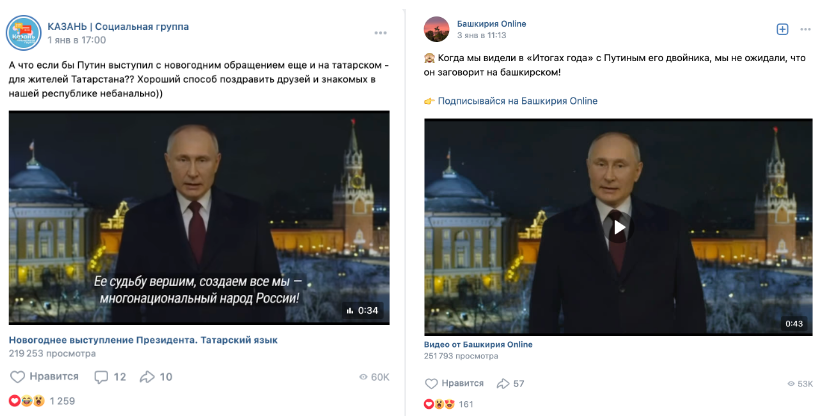

С помощью технологии дипфейк российский президент Владимир Путин поздравил россиян с началом 2024 года на национальных языках. Аудио с текстом было сгенерировано нейронной сетью, чтобы подстроить мимику под длительность слов и особенности фонетики, был изменен и видеоряд.

Дипфейки в обучении

Большие перспективы эксперты видят в вопросе использования дипфейка в сфере образования. Директор по науке и технологиям Агентства искусственного интеллекта Роман Душкин отметил, что с помощью технологии дипфейк можно расширить возможности чтения лекций для студентов.

Отметим, что тренд современного образования все больше смешается в сторону видеоформата. Ролики предпочитают больше, чем статьи, инфографику, презентации и книги. Дипфейки, основанные на технологии deep learning (глубокое обучение), в этой связи помогают быстро создать видеокурс.

Так, можно снять материал с преподавателем один раз, а потом нейронная сеть может менять язык, национальность и даже пол наставника. Подобные программы актуальны для корпоративного обучения, когда важно учить сотрудников по одним стандартам.

Темная сторона deepfake

Обучение искусственного интеллекта и расширение его сферы влияния происходит быстро. Дипфейки применяют не только для развлечения и создания полезного контента, технологию полюбили криминальные элементы. К примеру, известного человека могут шантажировать откровенными видеороликами, где используется его лицо. Начало постинга такого контента пришлось на 2017 год. Впоследствии Reddit, Twitter и Pornhub стали блокировать их в случае выявления.

Одним из последних громких случаев стал скандал с американской певицей Тейлор Свифт. 25 января 2024 года в соцсети X (ранее Twitter) были опубликованы изображения эротического характера, сгенерированные ИИ, где главной фигурой стал образ исполнительницы. Один из постов собрал более 45 млн просмотров, прежде чем аккаунт заблокировали. Платформа заявила об абсолютной нетерпимости к подобному контенту. Но тенденция остается «тревожной», как заметил СЕО Microsoft Сатья Наделла.

Помимо эротического контента дипфейки используют и для финансовых афер. Мошенники подделывают голоса, чтобы заставить жертву перевести деньги. Так, в 2019 году злоумышленники убедили работника одной из британских компаний перевести на их счет 240 тысяч долларов. Сделали они это, сгенерировав голос его руководителя.

Технологию голосовых дипфейков мошенники активно используют и в России. Аудио имитируют при помощи специальных программ. Как правило, все образцы голоса и сведения мошенники берут из соцсетей, а готовую подделку с требованием переслать деньги рассылают неопытным пользователям сети, к примеру, пожилым родственникам.

Кроме того, с помощью дипфейк-технологии можно взломать FaceID. Такая система защиты может не отличить реального пользователя от дипфейк-двойника.

Дипфейки стали использовать и в информационных войнах, для создания различного рода подделок, очерняющих политического оппонента, либо влияющих на настроения масс. Сейчас можно смело утверждать, что дипфейки становятся товаром на политическом рынке.

Создавая поддельные видео или изображения политических лидеров, злоумышленники могут подорвать доверие общества к институту демократии и вызвать политическую нестабильность. В крайних случаях дипфейки могут применяться для нагнетания хаоса и создания раскола в обществе.

Но зачастую подделки рассчитаны на эффект внезапности и неопытных пользователей. К примеру, летом прошлого года в ряде регионов РФ на радио и телевидении прозвучало фейковое обращение российского президента Владимира Путина, в котором сообщалось о введении военного положения и всеобщей мобилизации. Ролик разметили в результате взлома сетки вещания. Все тезисы оказались ложными. Целью вброса было посеять панику среди населения.

Инструменты для определения дипфейка

Большинство дипфейковых роликов можно без труда определить визуально: картинка кажется нечеткой и смазанной, есть мелькания, плохо проработаны глаза и зубы. Изображение на видео «скачет», голос кажется роботизированным и используются неестественные интонации. Машинное обучение заметно и остается местами очень грубым.

Но с развитием технологий подделки стали настолько искусными, что для их верификации нужны специальные программы. К примеру, FakeCatcher от Intel или DeepFake-Detection-SDK. Но и они не всегда показывают достоверные результаты. Так, DeepFake-Detection-SDK определил только с 12 из 20 дипфейков, созданных для анализа. У FakeCatcher показатель выше: 19 из 20.

На российском рынке хорошо зарекомендовала себя система под названием «Зефир». Данное программное обеспечение является разработкой АНО «Диалог Регионы». Оно глубоко исследует данные, идентифицирует поддельный аудиовизуальный контент и выдает процентную вероятность фейка. Благодаря этим алгоритмам уже были распознаны несколько дипфейковых видео с российским лидером.

К примеру, на прямой линии 14 декабря 2023 года президент РФ Владимир Путин получил вопрос от «самого себя». Российский студент использовал технологию дипфейка, что узнать у главы государства о наличии у него двойников и его отношении к возможностям искусственного интеллекта. «Зефир» определил ролик как фейк с вероятностью в 78%. Высокое качество подделки было связано с тем, что студент взял для образца реальное видео с выступления российского лидера.

Законно ли использовать технологию deepfake

Поскольку эта цифровая технология очень быстро распространилась не только в кино, но и криминальной среде, встал вопрос о законности ее использования. Из-за того, что это явление новое, законодательство еще не сформировано в полной мере. В российском законодательстве пока нет понятия дипфейк и законов с этим термином. Но есть смежные законы.

Так, согласно статье 152.1 ГК РФ, нельзя использовать изображение гражданина без его на то согласия. Если человек умер, то согласие должны предоставить его родственники. Даже если человек размещает фото или видеоконтент с собой в сети, то это не дает другим людям право использовать эти материалы без согласия.

То есть если при производстве дипфейка использовалось фото гражданина без его согласия, то таким образом нарушается право на охрану такого изображения, что может закончится юридической ответственностью.

Также у человека есть право на защиту чести, достоинства и деловой репутации. Если созданный дипфейк нанес урон деловой репутации и дискредитировал гражданина, то ответственность для нарушителя неминуема. Здесь же можно применить статью 128.1. УК РФ о клевете.

Большую опасность представляют набирающие популярность голосовые подделки, которые часто создают аферисты. С одной стороны, нигде в мире не распространено право собственности на голос. Но с другой стороны, как пояснили в Минцифры РФ, голосовые данные человека являются биометрией и охраняются законом «О персональных данных». Таким образом, использование чужого голоса без согласия человека, которому он принадлежит, может повлечь административную ответственность, поскольку это незаконная обработка персональных данных.

Также в рамках правового поля остается нарушение авторских прав посредством использования дипфейка, а также ответственность предусмотрена за создание недобросовестной и вводящей в заблуждение рекламы. Если обман был за счет использования данной технологии, то это также карается законом. Сейчас в Госдуме рассматривается вопрос о принятии соответствующего закона о дипфейках.

Расширить действующее законодательство в связи с ростом сферы применения нейронных сетей стремятся многие страны. В КНР в 2020 году была введена уголовная ответственность за введение в заблуждение с помощью дипфейков.

А в штате Калифорния в США вступили в силу законы, запрещающие генерировать откровенные кадры с использованием технологии дипфейк без согласия человека, а также создавать поддельные видео с участием кандидатов на государственные посты в преддверии выборов.

В ЕС и Великобритании также принят ряд законодательных актов, ограничивающих применение нейросетей.

Как защитить себя от недобросовестного использования ИИ

Если у вас возникли сомнения в подлинности аудио- или видеосообщения, которое вам отправили, то лучше все перепроверить несколько раз.

Важно провести беседу на тему безопасности в цифровой среде с неопытными пользователями сети, к примеру, с родственниками пожилого возраста и детьми. Можно также договориться с ними о кодовом слове или вопросе, которые будете знать только вы и ваши близкие. Также при видеобеседе с предполагаемым мошенником, попросите человека потрясти головой, в этом случае маска слетит. Если же он категорически отказывается это делать, то лучше прекратить разговор.

Также чтобы оградить себя от фейков в сети, важно проверять данные в авторитетных источниках.

Топ приложений для создания дипфейков в домашних условиях

Рынок приложений, в которых вы сможете с помощью ИИ создавать различного рода фотографии и видео с дипфейками невероятно широк. Большинство из них имеет бесплатный демонстрационный период, а далее необходимо оплатить подписку.

FaceApp

FaceApp является одним из наиболее известных сервисов для генерации дипфейков. Оно набрало почти 500 000 оценок в App Store. Есть версия и для Андроид.

Оно знаменито тем, что лицо можно трансформировать различными способами. Например, ИИ способен вас состарить, сделать фотомоделью, изменить пол, цвет волос, глаз прическу, надеть очки, добавить улыбку или усы. В нем также имеется возможность избавиться от проблем с кожей за счет применения фильтра Hollywood.

FaceApp доступны и бесплатно, но самые полезные маски и возможности открываются после приобретения платной версии.

Zao

Эта китайская разработка взорвала сеть в 2019 году. Сервис заняла топ-3 в Apple Store в КНР. Его функционал заключается в том, что человек заменить лицо героя известного фильма или сериал на свое и почувствовать себя знаменитостью или просто развлечься, создавая забавный видео-контент. Однако у разработчиков случились проблемы, связанные с политикой конфиденциальности. На данный момент Zao нельзя скачать в РФ.

FaceSwapLite

FaceSwapLite тестируется в бесплатном режиме. Суть технологии заключается в том, что лица на изображении меняются местами. Благодаря этому можно записать забавный ролик или сделать фото. Эту программу для дипфейков особенно полюбили владельцы домашних животных, которые записывали ролики вместе со своими любимцами. Также в функционале FaceSwapLite небольшой набор масок, например, Санта Клауса или викинга.

Несмотря на то, что FaceSwapLite упрекают в простоте и том, что контур схватывается неточно, тем не менее это хорошее развлечение на полчаса.

Avatarify

![]()

Суть Avatarify заключается в том, чтобы «оживить» фото и заставить его петь. Вы загружаете снимок, а нейросеть подстраивает мимику губ под выбранный трек. Так можно создавать любопытные ролики для соцсетей. Разработчики предлагают тематические подборки песен для дипфейка. Например, новогодние, детские, из знаменитых фильмов и так далее.

Avatarify предлагает freeware пробный период в три дня, а потом за его применение нужно заплатить. Avatarify доступ для установки на Айфон и Андроид-девайсы.

DeepFaceLab

В DeepFaceLab генерирует дипфейк с помощью более тонкого инструментария. Новичкам сложно с ним работать, и оно коммерческое, но в нем можно добиться впечатляющих и весьма реалистичных результатов. Разработчики, конечно, предусмотрели бесплатную версию. Но в ней доступна только функция замены местами головы на двух кадрах, добавление текста и стикеров, набор которых весьма ограничен.

В платной версии DeepFaceLab можно не только изменить черты, но и сделать себя моложе. Движения губ сервис синхронизирует с речью, что создает реалистичный эффект.

Программа с ограниченным набором функций есть в App Store, более полная версия на GitHub. Для работы с ней есть гайды на английском языке, а также видеообзоры.

Morph

Morph создает короткие ролики из загруженных вами снимков. К примеру, чтобы показать стадии взросления человека или возрастных изменений за время жизни.

При этом необязательно брать снимки одной персоны. Например, легко превратить Дэниела Рэдклиффа в Анджелину Джоли. Есть опция наложения музыки из библиотеки мелодий.

Приложение недоступно для Android, у него пробная версия и платная.

ToonMe

В этом приложении для дипфейков доступен пробный период в три дня, а далее для пользования нужно оформлять платную подписку. ToonMe доступно для Андроидов и iPhone. А название образовано от английского слова cartoon – «мультик». Это объясняет основные возможности данного ИИ-сервиса.

При загрузке исходного изображения оно превращается в мультяшный образ. Картинку, полученную в результате таких манипуляций, можно сделать гифкой. В галерее есть дополнительные эффекты.

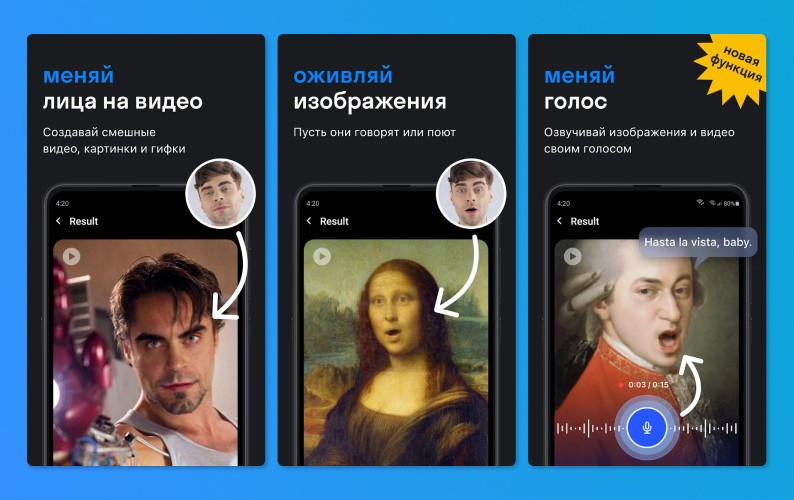

Reface

Эта разработка – аналог Zao, здесь каждый способен побывать в шкуре знаменитости. Схема работы приложения проста: загружаете свое селфи и нейросеть переносит вас на палубу «Титаника», вы становитесь героем боевика или ходите лунной походкой вместо Майкла Джексона.

Маски для дипфейков, которые доступны в Reface, смотрятся максимально естественно. Они не слетают и не добавляют неприятных шумов. Минус сервиса: большое количество рекламы. Избавиться от нее можно, если купить премиум-версию. В платном пакете предусмотрена высокая скорость загрузки и более четкое изображение.

Есть версии как для Андроид, так и для iOs.

Законно ли использовать deepfake

Поскольку эти возможности искусственного интеллекта использовались не только в целях развлечения, но и для мошеннических схем и шантажа, встал вопрос об их законности. К тому же открытой остается тема защиты от репутационных рисков. Но поскольку технология дипфейк новая, то и законодательство, которое бы регулировало эту сферу, еще не сформировано. Некоторые страны стремятся к тому, чтобы урегулировать использование нейросетей. Но законотворческая деятельность пока не успевает за развитием ИИ.

Так, в штате Калифорния (США) приняты два ограничительных закона, связанных применением этого инструмента. Согласно закону, нельзя создавать откровенные кадры без согласия человека, а также генерировать дипфейковые ролики с участием кандидатов на госпосты в преддверии выборов.

В ЕС и Великобритании на фоне обеспокоенности ростом влияния информационных технологий принят ряд законодательных актов. В России эту область регулирует закон о клевете, который предусматривает наказание вплоть до лишения свободы. Несмотря на то, что в законе нет слова «deepfake», наказание можно понести за нанесение урона деловой репутации.

Согласно статье 152.1 ГК РФ, нельзя использовать изображение гражданина без его согласия, а в случае его смерти согласие дают только его родственники. Кроме того, даже если сам гражданин размещает фото или видео с собой в сети, это не дает другим права свободно брать подобные материалы без получения согласия.

Поэтому при использовании фото гражданина для создания дипфейков нарушается его право на охрану такого изображения, что влечет для нарушителя юридическую ответственность

Большую опасность представляют голосовые подделки, которые часто создают мошенники, поскольку нигде в мире не распространено право собственности на голос.

Некоторые эксперты предполагают, что в ближайшем будущем обывателям будет все труднее отличать реальные образы от поддельных. Пока непонятно, как жертв недобросовестного использования технологий ИИ защитит закон, но ясно, что уже сейчас усложняются алгоритмы для распознавания видео, сделанных с помощью дипфейка. Важно помнить и о цифровой безопасности и с осторожностью относится к голосовой почте и видеозвонкам. Если у вас возникнуть подозрения в подлинности ролика, то лучше все перепроверить еще раз.

Также важно провести беседу на тему цифровой безопасности с неопытными пользователями, к примеру, с пожилыми родственниками. Всегда важно проверять информацию, даже если она идет от известного «ньюсмейкера».

Хотите опубликовать свой разбор на сайте «Лапша Медиа»? Как это сделать — подробно рассказываем здесь.