Дипфейки активно внедряются в интернет-пространство. Эту технологию используют для искусства, привлечения внимания к социально значимым проектам и развлечения. Однако инструментом умело жонглируют и злоумышленники. Дипфейк часто применяется для шантажа, мошенничеств и черного пиара в политике.

Подробнее — в нашем материале.

Что такое дипфейк?

Сам термин происходит от английского словосочетания: deep learning — «глубинное обучение», и слова fake — «подделка». Если говорить простыми словам, то дипфейк — это когда настоящее лицо человека на видео или фото подменяется другим с помощью ИИ. Этим методом подменяют и голос.

Благодаря этой технологии создают видеоролики, на которых человек выполняет и произносит то, что никогда в жизни не делал и не говорил. Если нужно, чтобы в «Терминаторе» был не Арнольд Шварценеггер, а Бред Питт — дипфейк поможет.

Как эволюционировали дипфейки

Если сначала подобный инструмент искусственного интеллекта был доступен только в киноиндустрии, например, для Голума из саги «Властелин колец», то со временем возможности совершенствовались. Так, при создании персонажей фильма «Аватар» использовали новую технологию анимации лица facial motion retargeting. С ее помощью переносили мимику людей на трехмерных героев. До этого нововведения при съемках подобных кинолент система захвата движений являлась общей.

Сейчас же эти возможности и сложные инструменты ИИ доступны широкому кругу пользователей. Теперь можно создавать дипфейки легко, например, с телефона или другого гаджета.

Но как же создается такая трансформация замены лиц людей? В основе технологии генерации видео в реальном времени лежат нейронные сети. Эта математическая модель, которая работает по тем же принципам, что и наш мозг, поэтому она способна к самообучению.

Процесс основывается на автоматизированном обучении. В создании дипфейка участвуют две нейронные сети. Первая — генерирует лица или голоса, а вторая определяет, похожи результаты синтеза на оригинал или нет. Нейросети учатся друг у друга, пока вторая не сможет отличить копию, созданную первой нейронкой, от образа оригинала. Этот механизм глубокого обучения называется генеративно-состязательной сетью (GAN).

Для создания контента этим методом нужны запись голоса и фото или видео. С медийными личностями все просто: в интернете много исходных изображений с их участием. Если вы не знаменитость, то образцы вашего голоса и фото находят в соцсетях и мессенджерах. Голосовых сообщений в общих чатах и пары десятков снимков достаточно, чтобы сделать среднего качества фейк, который выглядит и говорит как вы.

Как применяют дипфейки с пользой

Инструмент широко распространен в различных сферах: от маркетинга до образования. Особенно технологию дипфейк полюбили художники и дизайнеры, которые часто применяют ИИ в творческих проектах. Так, компания «МегаФон» использовала ее с актером Брюсом Уиллисом при съемках рекламы. «Двойник» голливудской знаменитости помог ускорить и удешевить процесс съемок видео.

А к 115-летию испанского художника Сальвадора Дали специалисты создали его цифровую версию. Виртуальный гений очень похож на оригинал, посетители разговаривали с ним и даже делали селфи.

В 2020 году завирусился ролик, на котором бизнесмен Илон Маск поет советских шлягер «Трава у дома» группы «Земляне». Обзавестись вокальным талантом предпринимателю тоже помогла нейросеть.

Отметим, что персона создателя соцсети X (бывший Twitter) очень популярна и часто используется при создании подобного рода видео дипфейков. Так, на форуме «Диалог о фейках», который состоялся 22 ноября 2023 года в Москве, каждый желающий «примерял» его лицо с помощью специальной программы. Примечательно, что Илон Маск, а точнее его виртуальный двойник, сделанный ИИ, пригласил сам себя на форум.

Иногда дипфейки людей применяют для различного рода социальных кампаний. Так, одна американская НКО решила «оживить» Хоакина Оливера, который погиб в результате стрельбы, произошедшей в школе в 2018 году. Виртуальная копия подростка призвала зрителей проголосовать на выборах за политиков, которые выступают за ограничение ношения оружия.

Однако после выхода ролика в соцсетях началась полемика, появились критические комментарии об этичности использования технологии для воссоздания образа умершего человека, который уже не сможет высказать свою позицию самостоятельно. Тем не менее ролик привлек внимание общественности к проблеме ношения оружия.

В последнем эпизоде российского сериала «Диверсант» с применением дипфейка воссоздали персонажа погибшего актера Влада Галкина. Проект реализовали с согласия родственников. Отметим, что это не эпизод на несколько секунд, а большая роль – видео длилось восемь минут.

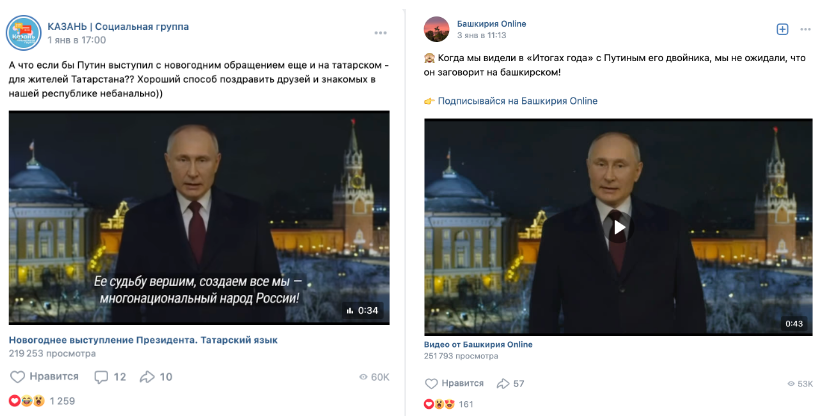

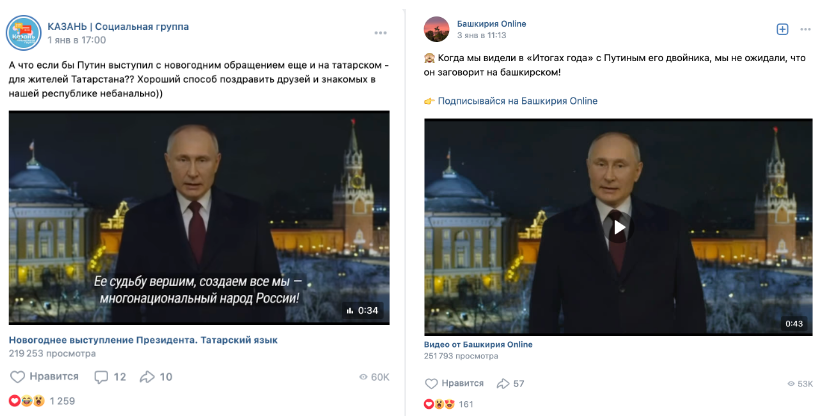

С помощью технологии deepfake поздравление президента РФ Владимира Путина по случаю начала 2024 года перевели на национальные языки. В видео-подделках глава государства поздравляет россиян на татарском, чеченском, башкирском, чувашском, алтайском, тувинском, ингушском, кабардинском и балкарском языках. Аудиодорожки с текстом сгенерированы с использованием нейросети, также изменен и видеоряд, чтобы подстроить мимику под длительность слов и особенности произношения.

В целом использование нейросетей бывает вполне невинным и применяться для развлечения. Так, с помощью ИИ оживляют на видео Мону Лизу, а лицо Брэда Питта добавляют Терминатору. Нейросеть даже создает изображения персонажей, которые похожи на настоящего человека. К примеру, как блогер-инфлюэнсер Лил Микела (Lil Miquela), у которой 3,6 млн подписчиков в одной из социальных сетей.

Опасность дипфейков для общества

Технологию дипфейк применяют не только для искусства, других благих намерений или развлечения, но и для разного рода махинаций и мошеннических схем. К примеру, известных актеров могут шантажировать откровенными видеороликами, где используются их лица. А обнародование такого контента нанесет урон по репутации знаменитостей. Подобного рода видео стали активно создавать с 2017 года. Но многие сайты успели их запретить и блокируют подобный контент в случае выявления. Речь идет о Reddit, Twitter и Pornhub.

Есть и другие случаи мошенничеств. Аферисты подделывают голоса, чтобы убедить перевести им деньги. К примеру, в 2019 году мошенники убедили сотрудника крупной компании перевести крупную сумму на их счета. Для этого они использовали голосовые дипфейки, создав голос его руководителя. Ущерб составил 240 тысяч долларов.

Используя ИИ злоумышленники создают различного рода компрометирующие кадры, а потом шантажировать жертву. Это случилось с индийской журналисткой Раной Айюб. Она занималась расследованиями и разоблачала злоупотребления власти. Видео с ее «участием» завирусилось, и это стало для нее тяжелым испытанием.

Кроме того, FaceID далеко не совершенна. Она может не различать работу нейросети от реального пользователя, и обход FaceID в банковских приложениях считается одним из примеров того, как мошенники могут использовать deepfake.

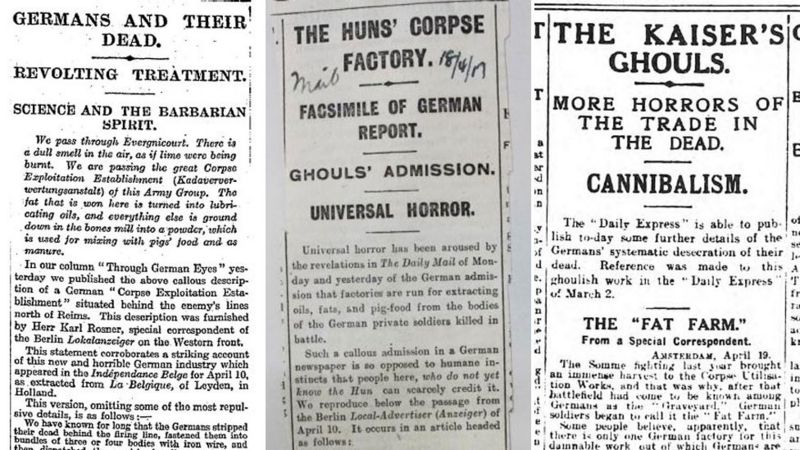

Фальшивки создают и для дезинформации. С помощью дипфейков влияют на массы, меняют вектор общественной мысли, что особенно актуально в контексте информационных войн современности. Зачастую подделки направлены на неопытных пользователей, а также рассчитаны на эффект внезапности.

На данный момент можно констатировать, что злонамеренное использование технологии со временем превращается в товар на политической сцене.

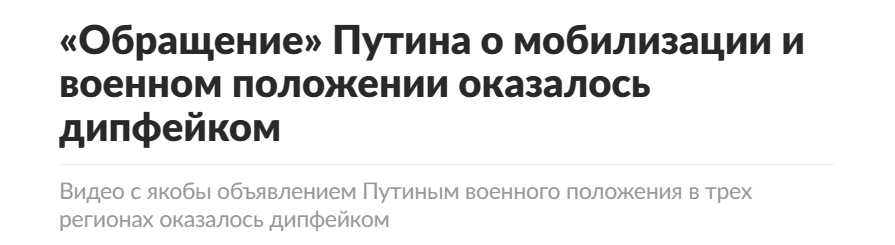

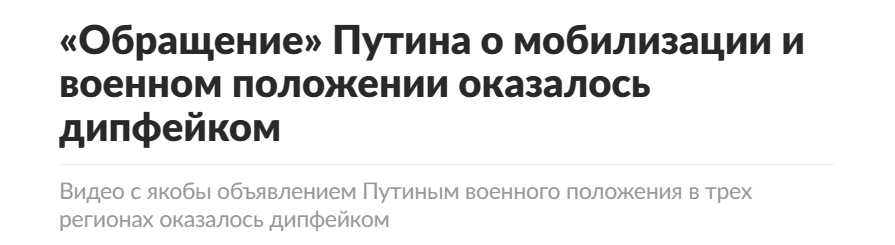

Так, летом 2023 года в ряде российских регионов на радиостанциях и телевидении прозвучало фейковое обращение от лица главы государства Владимира Путина. В нем сообщалось о введении в трех областях страны военного положения, а также об объявлении всеобщей мобилизации. Ролик оказался подделкой. Все тезисы обращения тоже оказались ложными. Его разместили в результате взлома сетки вещания телеканалов. Целью дипфейка было дестабилизировать обстановку и посеять в обществе панику.

Как отличить дипфейк на глаз

Качество замены на видео зависит от того, на каком количестве данных обучалась нейросеть. Чем больше данных — тем выше качество фейка. Но технология пока не так совершенна, чтобы обычный пользователь не смог не заметить работу ИИ. Есть несколько способов отличить его от оригинала на глаз:

- Обратите внимание на разницу в качестве картинки. Если перед вами подделка, то вы невооруженным глазом заметите отличия в четкости прорисовки лица и остальной части видео. Увидели, что у какой-то части ролика ниже разрешение, — перед вами монтаж. Как на этом видео, где к телу актрисы «пририсовали» голову королевы Англии Елизаветы II.

2. Приглядитесь, насколько пропорционально смотрятся части тела. Нереальные размеры лица или других частей тела свидетельствуют о подделке. Обычно при наложении головы одного человека на тело другого нарушаются пропорции. Если масштабы объектов на видео не совпадают, то перед вами обман. Например, в этом ролике головы Трампа и Байдена смотрятся непропорционального на фоне остальной массовки.

![TRUMP vs BIDEN [DeepFake]](https://i.ytimg.com/vi/cxnsIUDpi-g/hqdefault.jpg)

3. Посмотрите, как выполнены переходы между сценами. Часто они выглядят неестественно. Например, при смене кадра части лица могут постепенно меняться между оригиналом и подменой. При синтезе изображения борода и усы, родимые пятна, глаза, нос порой теряют в качестве или на время появляются не в тех местах. Например, как на этом ролике, где голову Аль Пачино с помощью ИИ наложили на актера Билла Хантера.

![Spot on Al Pacino impression by Bill Hader [DeepFake]](https://i.ytimg.com/vi/kjI-JaRWG7s/hqdefault.jpg)

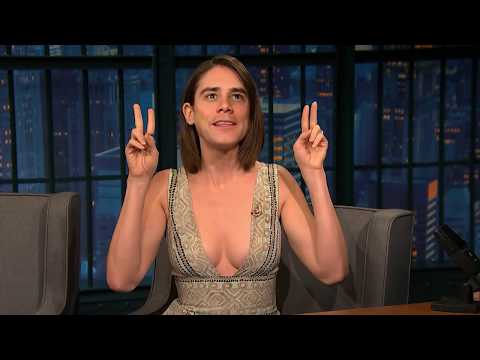

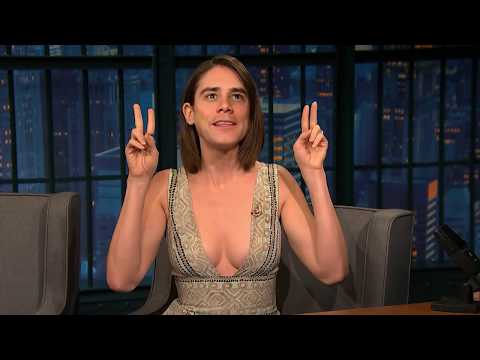

4. Соотнесите цвет кожи в разных частях видео. Сопоставляя оттенки кожи в разных частях тела, можно увидеть разницу в цвете текстуры. Особенно хорошо это заметно, если у оригинала и подмены разные цвета или оттенки кожи. Например, в этом ролике на тело актрисы Элиссон Бри «приклеили» лицо Джима Керри. Этот дипфейк отлично демонстрирует разницу в тоне кожи на теле и на голове.

5. Обратите внимание на зубы и цвет глаз. Для технологии deepfake по-прежнему сложно рисовать зубы, это своего рода проблема проблем. Также у человека на изображении бывает разный цвет глаз.

Инструмент для определения дипфейков

Дипфейки оказались новым вызовом в сфере информационной безопасности. Однако инструменты для их проверки уже есть, и они входят в обиход. К примеру, FakeCatcher от Intel или DeepFake-Detection-SDK.

FakeCatcher определил 19 из 20 созданных для анализа дипфейков. DeepFake-Detection-SDK справился только с 12 из 20.

На российском рынке зарекомендовала себя система «Зефир», разработанная АНО «Диалог Регионы». Данная программа помогает выявлять сфабрикованный аудиовизуальный контент. Алгоритмы «Зефира» уже помогли распознать несколько фейковых обращений с Владимиром Путиным. На одном он якобы говорил о взаимодействии с Украиной, а на другом — о необходимости всеобщей мобилизации. Этот кейс мы упомянули выше.

«Зефир» высчитывает процентную вероятность дипфейка. К примеру, на прямой линии 14 декабря 2023 года Владимир Путин получил вопрос от «самого себя». Российский студент применил технологию и спросил главу государства о наличии у него двойников и его отношении к искусственному интеллекту. Анализ видеовопроса от «Зефира» показал вероятность в 78%.

Топ приложений для создания дипфейков в домашних условиях

Рынок приложений, в которых вы сможете с помощью ИИ создавать различного рода фотографии и видео с дипфейками невероятно широк. Большинство из них имеет бесплатный демонстрационный период, а далее необходимо оплатить подписку.

FaceApp

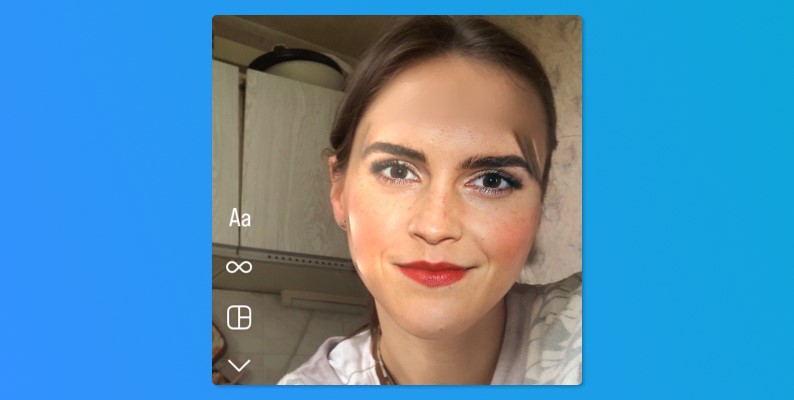

FaceApp является одним из наиболее известных сервисов для генерации дипфейков. Оно набрало почти 500 000 оценок в App Store. Есть версия и для Андроид.

Оно знаменито тем, что лицо можно трансформировать различными способами. Например, ИИ способен вас состарить, сделать фотомоделью, изменить пол, цвет волос, глаз прическу, надеть очки, добавить улыбку или усы. В нем также имеется возможность избавиться от проблем с кожей за счет применения фильтра Hollywood.

FaceApp доступны и бесплатно, но самые полезные маски и возможности открываются после приобретения платной версии.

Zao

Эта китайская разработка взорвала сеть в 2019 году. Сервис заняла топ-3 в Apple Store в КНР. Его функционал заключается в том, что человек заменить лицо героя известного фильма или сериал на свое и почувствовать себя знаменитостью или просто развлечься, создавая забавный видео-контент. Однако у разработчиков случились проблемы, связанные с политикой конфиденциальности. На данный момент Zao нельзя скачать в РФ.

FaceSwapLite

FaceSwapLite тестируется в бесплатном режиме. Суть технологии заключается в том, что лица на изображении меняются местами. Благодаря этому можно записать забавный ролик или сделать фото. Эту программу для дипфейков особенно полюбили владельцы домашних животных, которые записывали ролики вместе со своими любимцами. Также в функционале FaceSwapLite небольшой набор масок, например, Санта Клауса или викинга.

Несмотря на то, что FaceSwapLite упрекают в простоте и том, что контур схватывается неточно, тем не менее это хорошее развлечение на полчаса.

Avatarify

Суть Avatarify заключается в том, чтобы «оживить» фото и заставить его петь. Вы загружаете снимок, а нейросеть подстраивает мимику губ под выбранный трек. Так можно создавать любопытные ролики для соцсетей. Разработчики предлагают тематические подборки песен для дипфейка. Например, новогодние, детские, из знаменитых фильмов и так далее.

Avatarify предлагает freeware пробный период в три дня, а потом за его применение нужно заплатить. Avatarify доступ для установки на Айфон и Андроид-девайсы.

DeepFaceLab

В DeepFaceLab генерирует дипфейк с помощью более тонкого инструментария. Новичкам сложно с ним работать, и оно коммерческое, но в нем можно добиться впечатляющих и весьма реалистичных результатов. Разработчики, конечно, предусмотрели бесплатную версию. Но в ней доступна только функция замены местами головы на двух кадрах, добавление текста и стикеров, набор которых весьма ограничен.

В платной версии DeepFaceLab можно не только изменить черты, но и сделать себя моложе. Движения губ сервис синхронизирует с речью, что создает реалистичный эффект.

Программа с ограниченным набором функций есть в App Store, более полная версия на GitHub. Для работы с ней есть гайды на английском языке, а также видеообзоры.

Morph

Morph создает короткие ролики из загруженных вами снимков. К примеру, чтобы показать стадии взросления человека или возрастных изменений за время жизни.

При этом необязательно брать снимки одной персоны. Например, легко превратить Дэниела Рэдклиффа в Анджелину Джоли. Есть опция наложения музыки из библиотеки мелодий.

Приложение недоступно для Android, у него пробная версия и платная.

ToonMe

В этом приложении для дипфейков доступен пробный период в три дня, а далее для пользования нужно оформлять платную подписку. ToonMe доступно для Андроидов и iPhone. А название образовано от английского слова cartoon – «мультик». Это объясняет основные возможности данного ИИ-сервиса.

При загрузке исходного изображения оно превращается в мультяшный образ. Картинку, полученную в результате таких манипуляций, можно сделать гифкой. В галерее есть дополнительные эффекты.

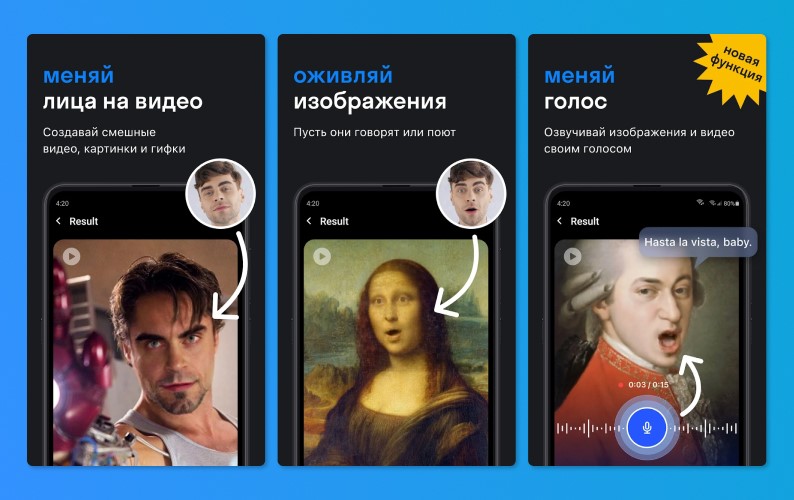

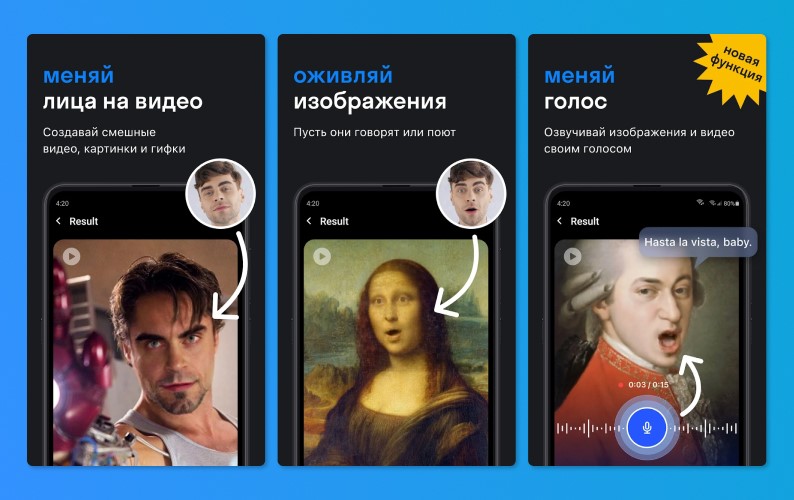

Reface

Эта разработка – аналог Zao, здесь каждый способен побывать в шкуре знаменитости. Схема работы приложения проста: загружаете свое селфи и нейросеть переносит вас на палубу «Титаника», вы становитесь героем боевика или ходите лунной походкой вместо Майкла Джексона.

Маски для дипфейков, которые доступны в Reface, смотрятся максимально естественно. Они не слетают и не добавляют неприятных шумов. Минус сервиса: большое количество рекламы. Избавиться от нее можно, если купить премиум-версию. В платном пакете предусмотрена высокая скорость загрузки и более четкое изображение.

Есть версии как для Андроид, так и для iOs.

Законно ли использовать deepfake

Поскольку эти возможности искусственного интеллекта использовались не только в целях развлечения, но и для мошеннических схем и шантажа, встал вопрос об их законности. К тому же открытой остается тема защиты от репутационных рисков. Но поскольку технология дипфейк новая, то и законодательство, которое бы регулировало эту сферу, еще не сформировано. Некоторые страны стремятся к тому, чтобы урегулировать использование нейросетей. Но законотворческая деятельность пока не успевает за развитием ИИ.

Так, в штате Калифорния (США) приняты два ограничительных закона, связанных применением этого инструмента. Согласно закону, нельзя создавать откровенные кадры без согласия человека, а также генерировать дипфейковые ролики с участием кандидатов на госпосты в преддверии выборов.

В ЕС и Великобритании на фоне обеспокоенности ростом влияния информационных технологий принят ряд законодательных актов. В России эту область регулирует закон о клевете, который предусматривает наказание вплоть до лишения свободы. Несмотря на то, что в законе нет слова «deepfake», наказание можно понести за нанесение урона деловой репутации.

Согласно статье 152.1 ГК РФ, нельзя использовать изображение гражданина без его согласия, а в случае его смерти согласие дают только его родственники. Кроме того, даже если сам гражданин размещает фото или видео с собой в сети, это не дает другим права свободно брать подобные материалы без получения согласия.

Поэтому при использовании фото гражданина для создания дипфейков нарушается его право на охрану такого изображения, что влечет для нарушителя юридическую ответственность

Большую опасность представляют голосовые подделки, которые часто создают мошенники, поскольку нигде в мире не распространено право собственности на голос.

Некоторые эксперты предполагают, что в ближайшем будущем обывателям будет все труднее отличать реальные образы от поддельных. Пока непонятно, как жертв недобросовестного использования технологий ИИ защитит закон, но ясно, что уже сейчас усложняются алгоритмы для распознавания видео, сделанных с помощью дипфейка. Важно помнить и о цифровой безопасности и с осторожностью относится к голосовой почте и видеозвонкам. Если у вас возникнуть подозрения в подлинности ролика, то лучше все перепроверить еще раз.

Также важно провести беседу на тему цифровой безопасности с неопытными пользователями, к примеру, с пожилыми родственниками. Всегда важно проверять информацию, даже если она идет от известного «ньюсмейкера».

![TRUMP vs BIDEN [DeepFake]](https://i.ytimg.com/vi/cxnsIUDpi-g/hqdefault.jpg)

![Spot on Al Pacino impression by Bill Hader [DeepFake]](https://i.ytimg.com/vi/kjI-JaRWG7s/hqdefault.jpg)

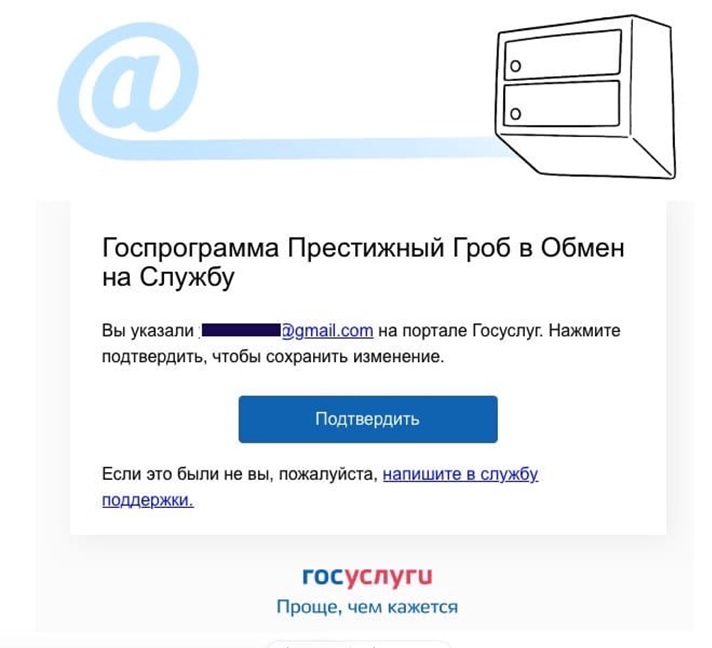

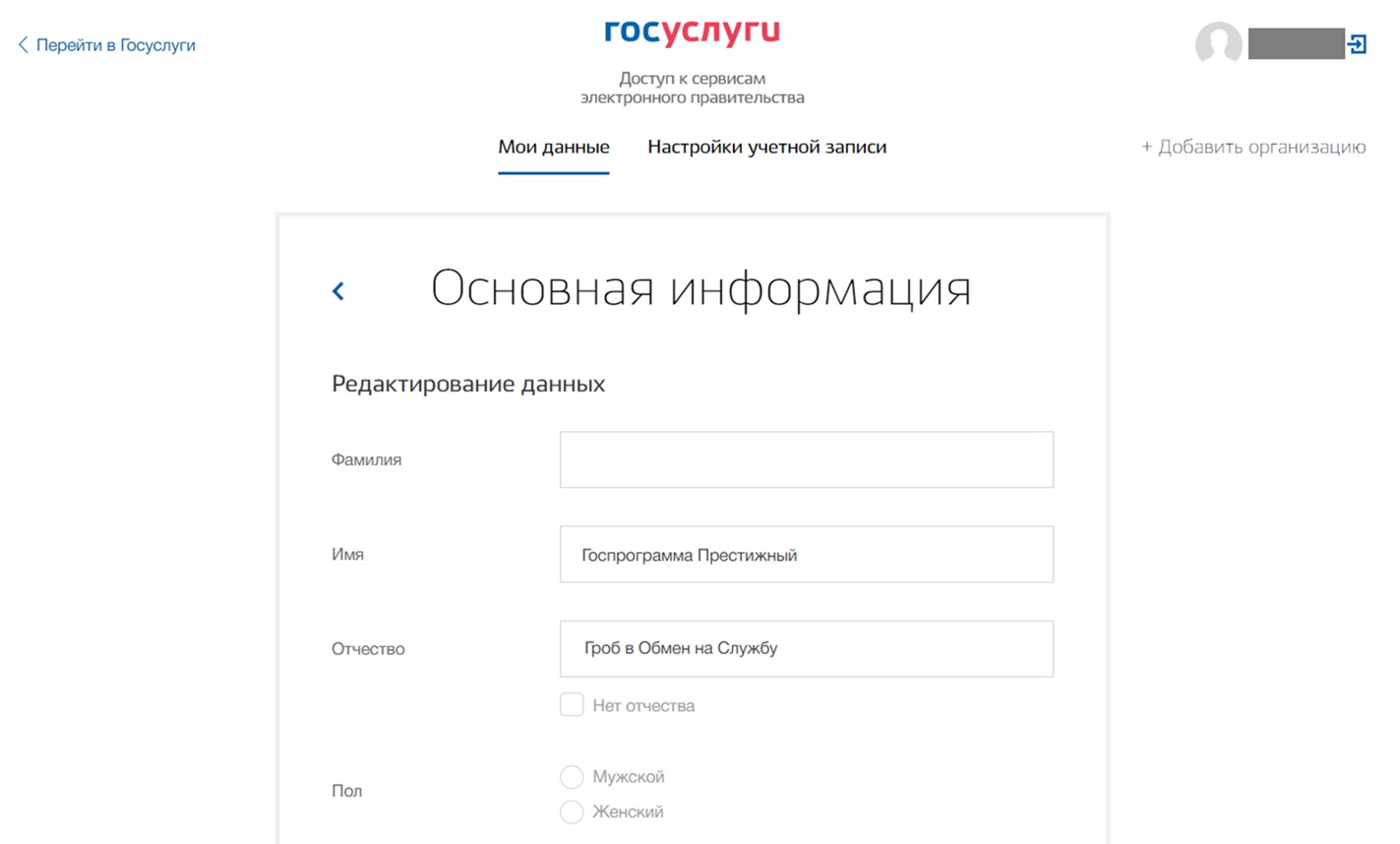

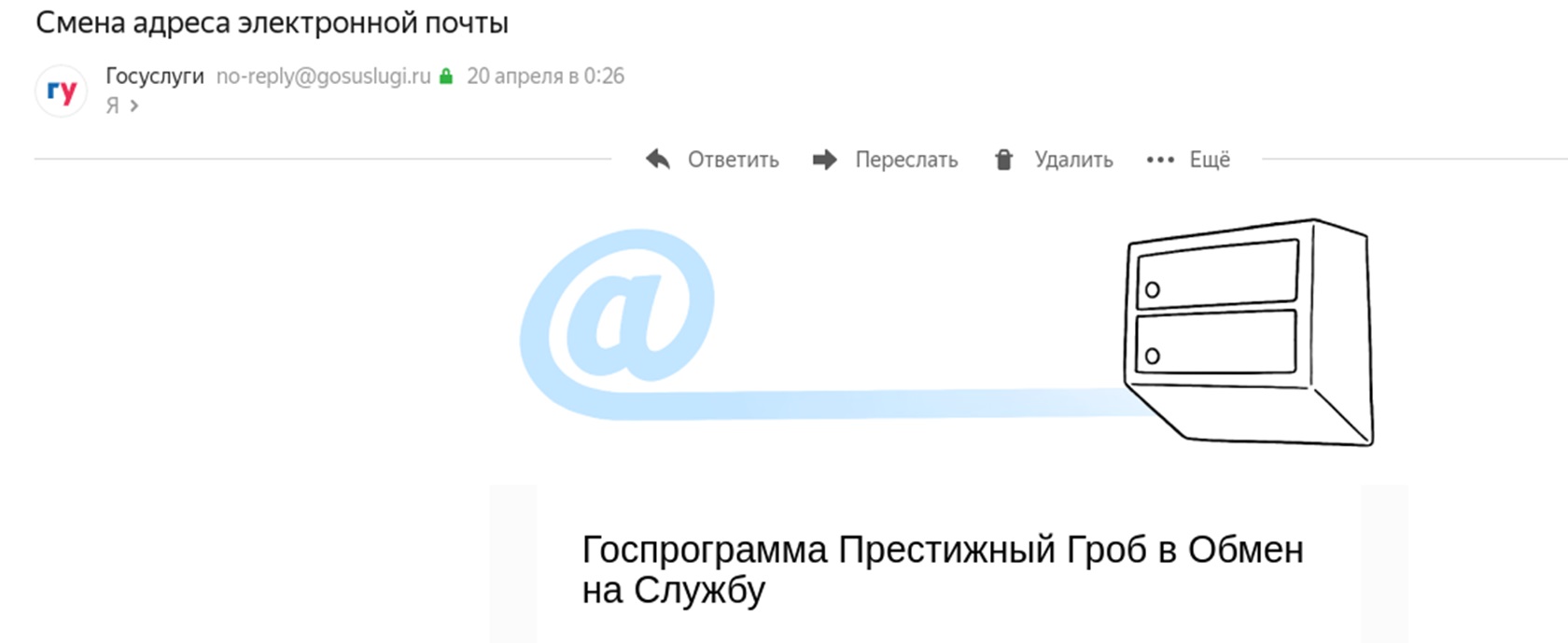

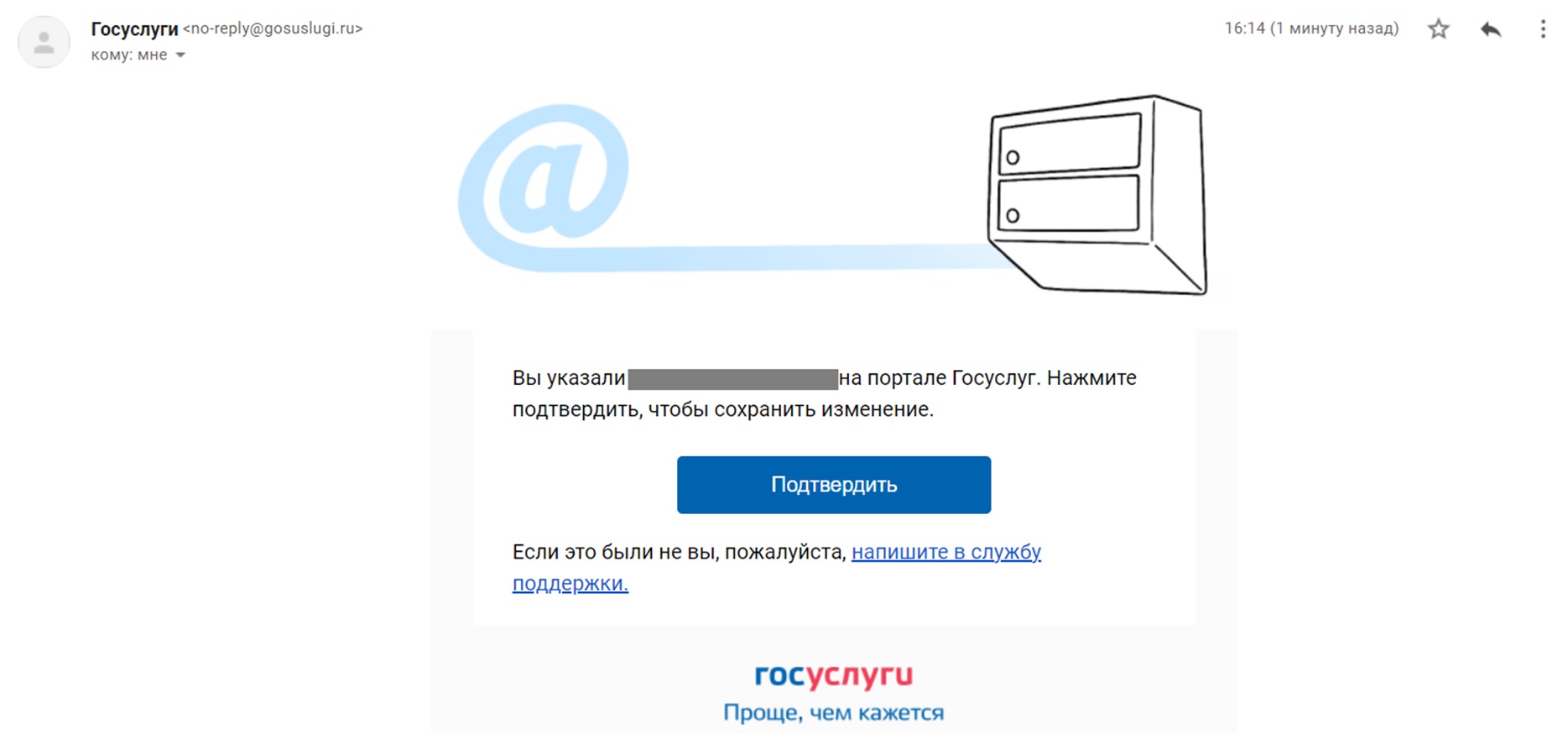

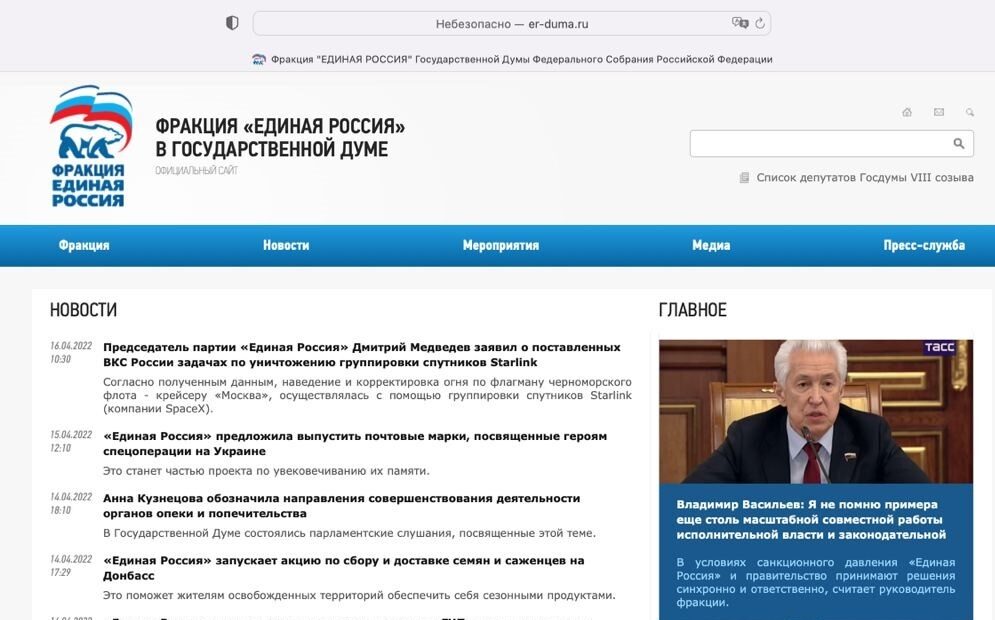

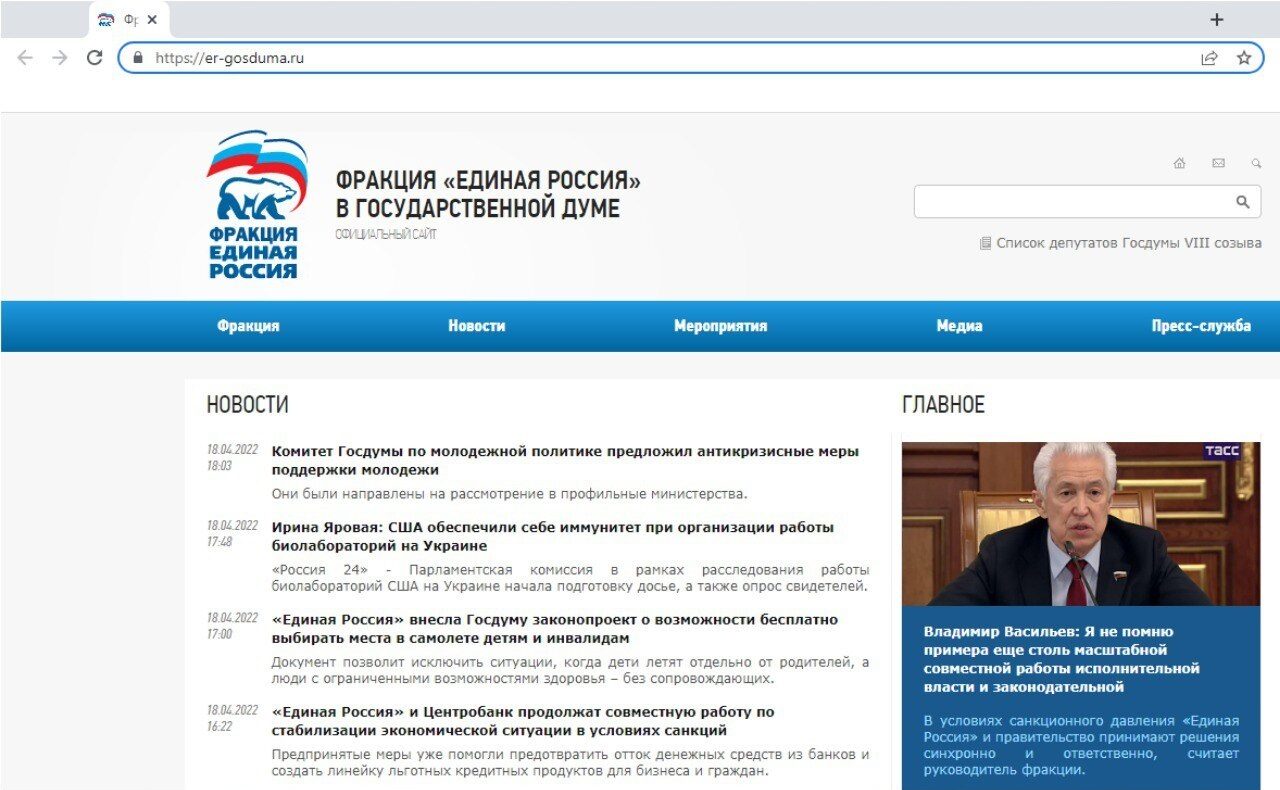

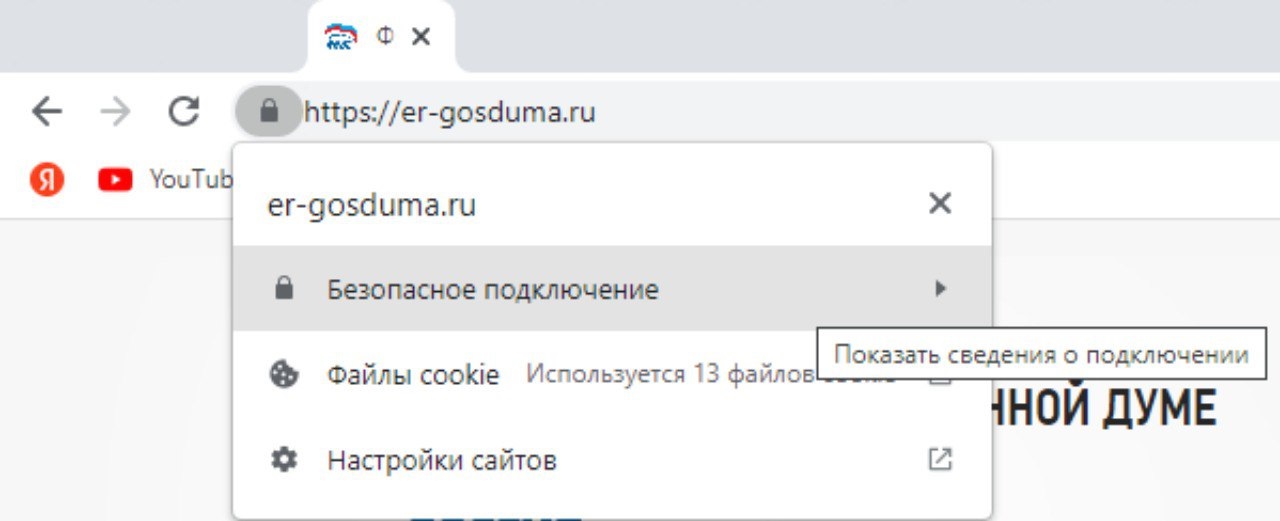

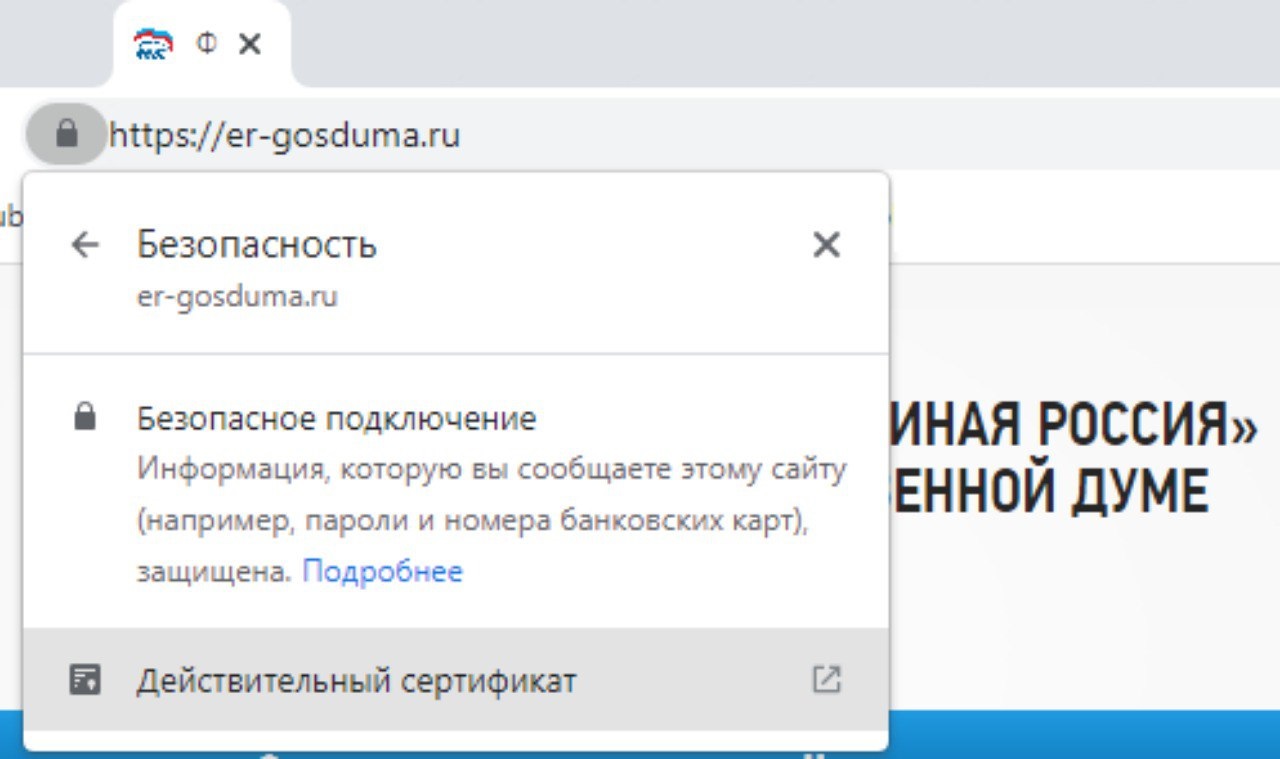

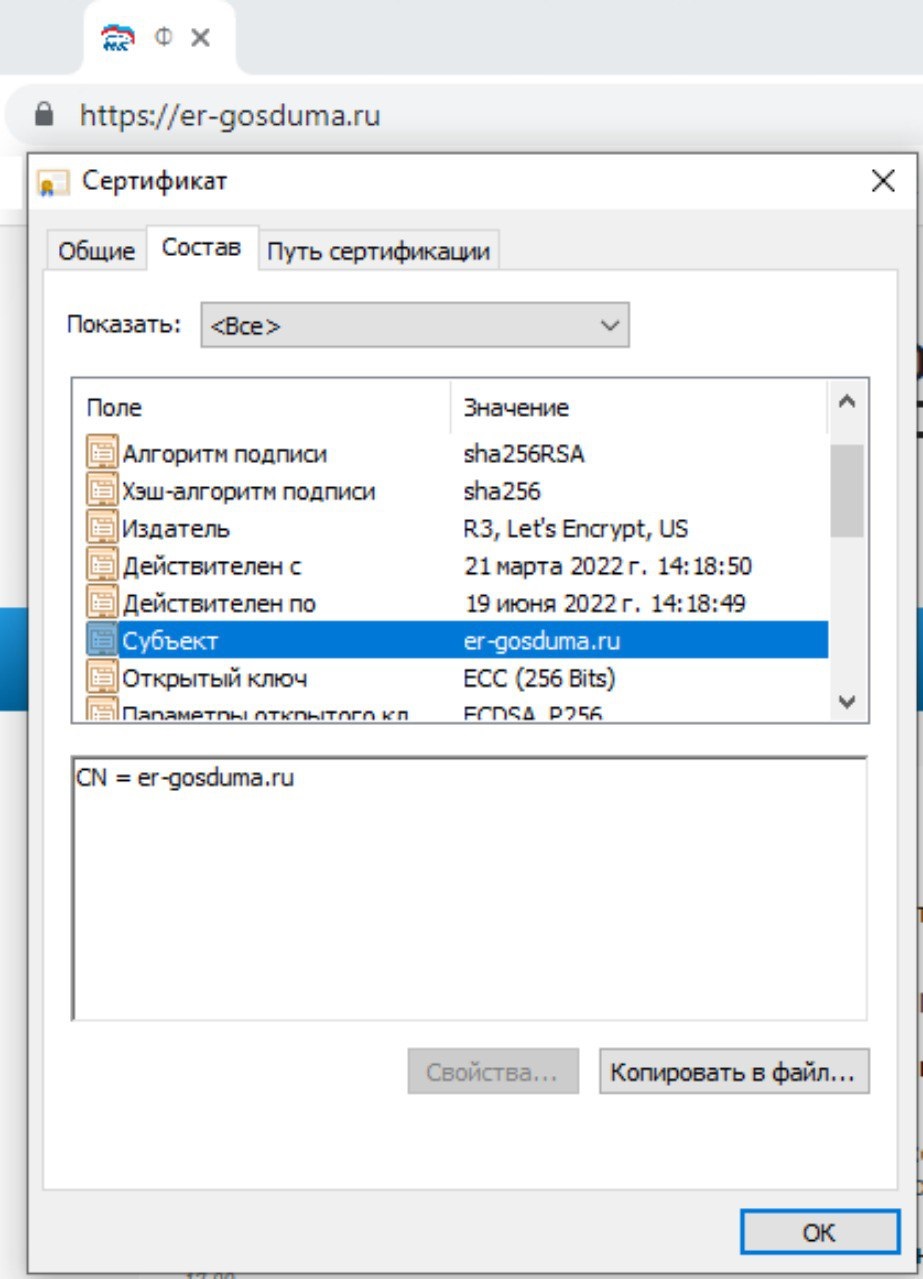

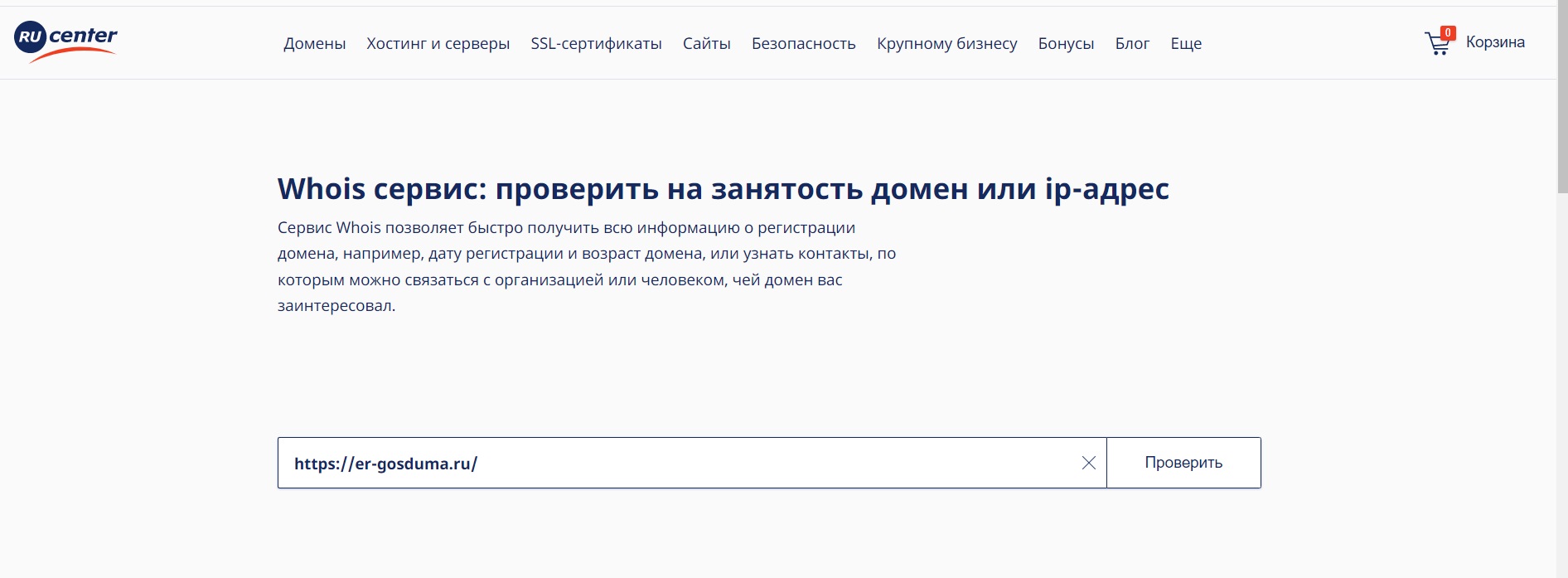

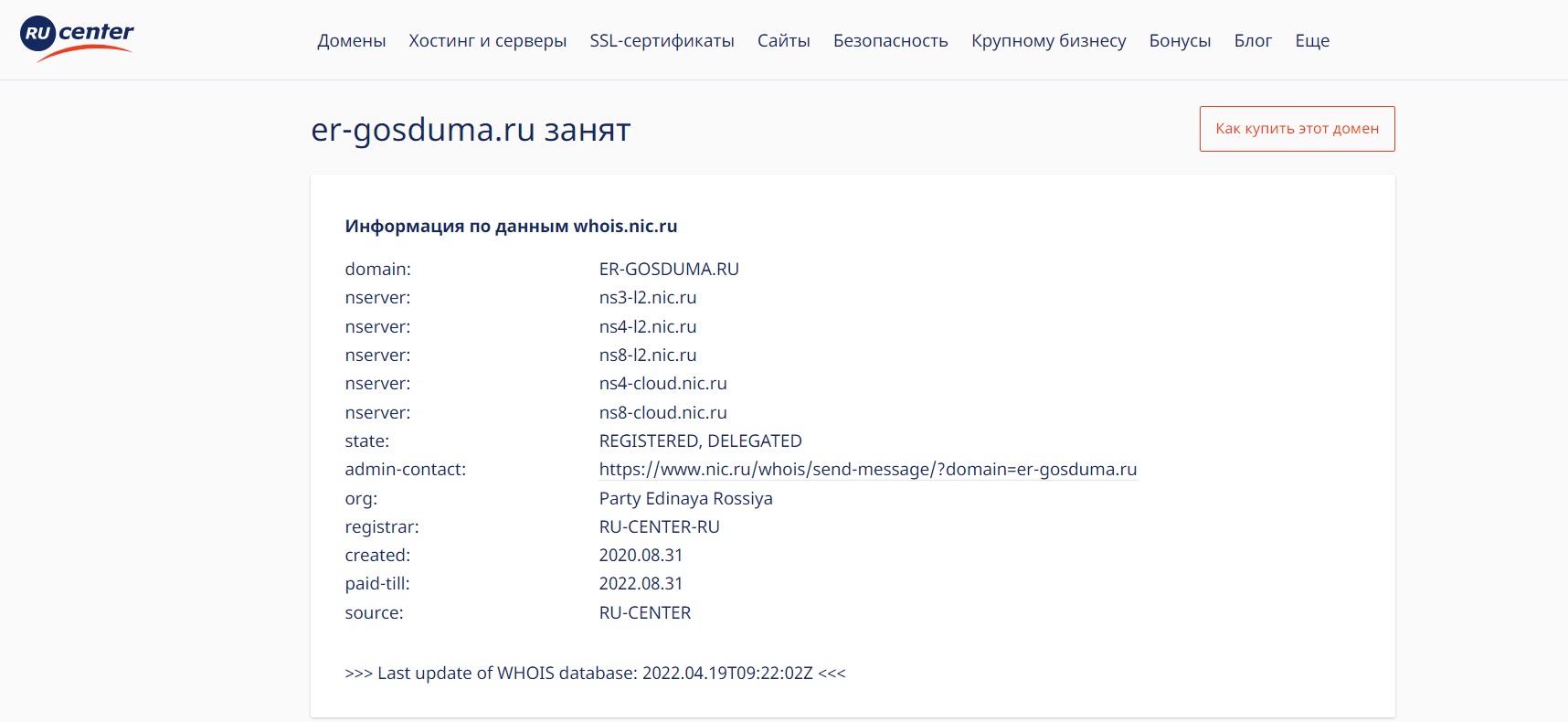

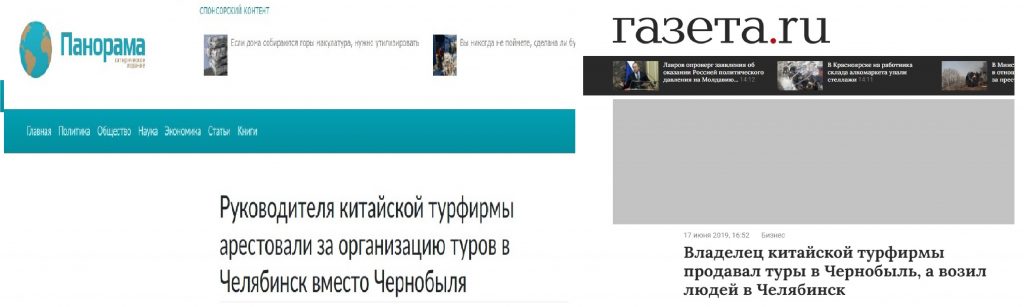

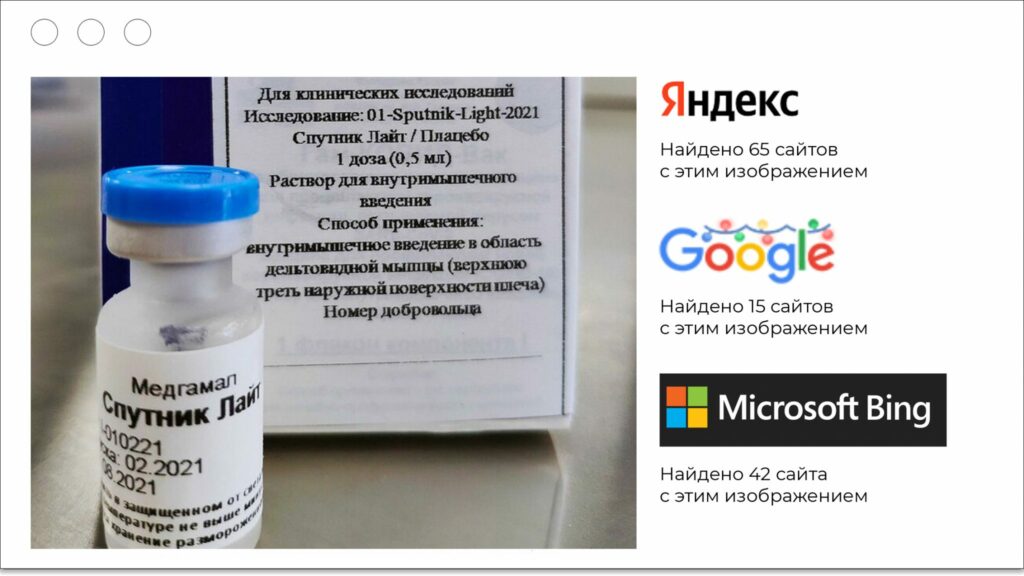

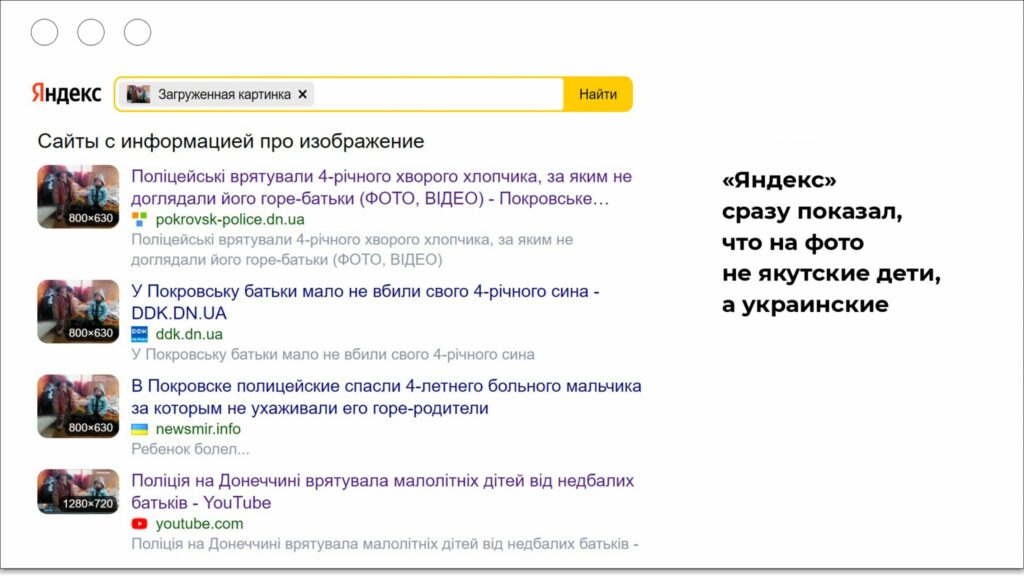

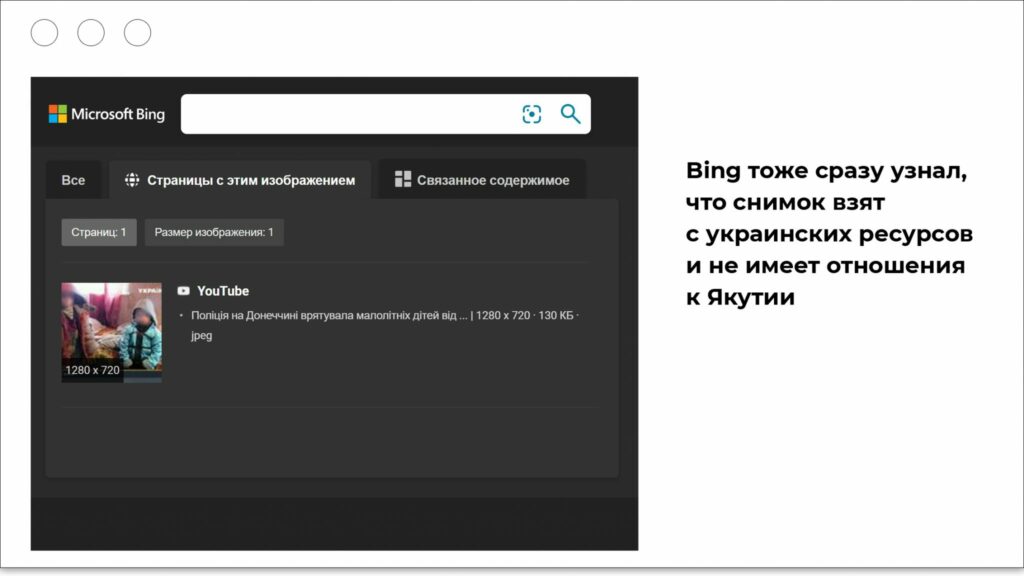

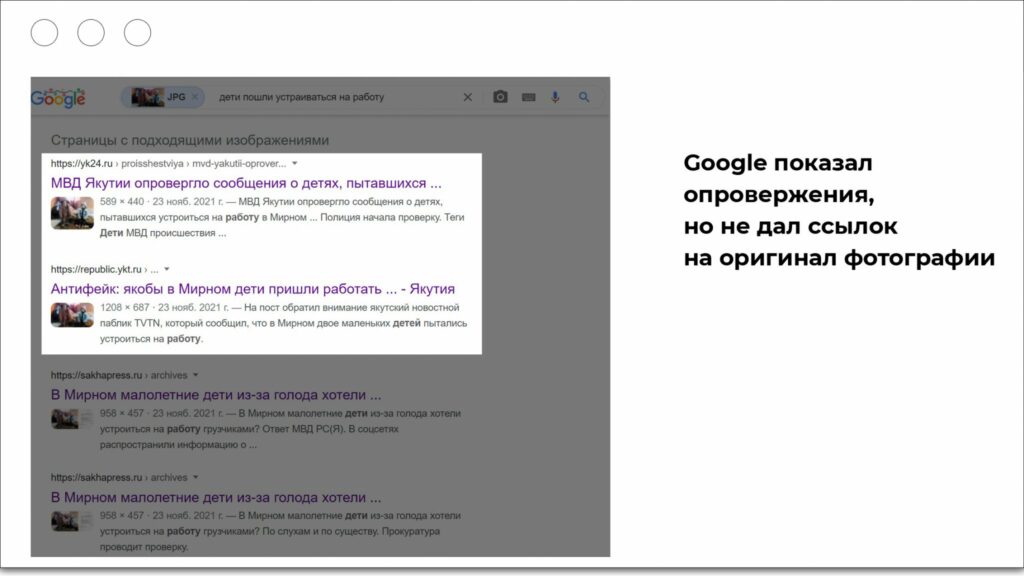

Иногда, чтобы понять фейк перед вами или нет, достаточно посмотреть, какую фотографию использует автор.

Иногда, чтобы понять фейк перед вами или нет, достаточно посмотреть, какую фотографию использует автор.

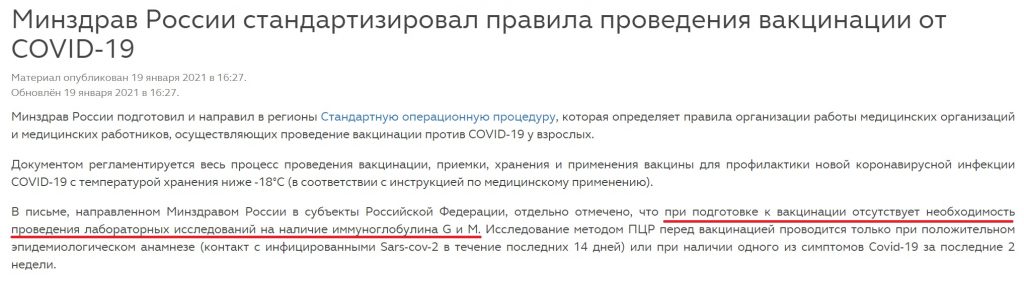

Новость на сайте Минздрава: перед вакцинацией не надо делать тест на антитела

Новость на сайте Минздрава: перед вакцинацией не надо делать тест на антитела